1. Introduction au module caméra

Module de caméra, nom complet Camera Compact Module, abrégé en CCM. Le CCM comprend plusieurs composants principaux : objectif, moteur à bobine mobile (VCM), capteur, circuit imprimé flexible (FPC), puce de traitement d'image (DSP).

Principe de fonctionnement : La lumière recueillie par l'objet à travers l'objectif est convertie en un signal électrique via le circuit intégré CMOS ou CCD, puis convertie en un signal d'image numérique via le processeur d'image interne (ISP) et transmise au processeur de signal numérique (DSP) pour traitement et conversion en un signal d'image standard GRB, YUV et autre format.

Le module caméra se compose principalement des éléments suivants :

Objectif : focalise la lumière sur le capteur d'image.

Moteur à bobine mobile (VCM) : complète l'autofocus de l'appareil photo.

Filtre IR : filtre la lumière invisible à l’œil humain.

Capteur d'image : convertit les signaux lumineux en signaux électriques.

Carte de circuit imprimé flexible (FPCB) : connecte le module de caméra au processeur principal et transmet les données.

La figure suivante montre la structure de plusieurs composants principaux d’un module d’appareil photo de téléphone mobile courant.

2. Composition

1. Lentille

La fonction principale de l'objectif est de faire converger la lumière collectée du monde extérieur vers le capteur d'image. Le principe est l'imagerie sténopé. Avec différents objectifs, la lumière est focalisée sur la puce photosensible située au bas de l'objectif (c'est-à-dire le capteur) pour former

Les objectifs modernes sont généralement composés de plusieurs lentilles pour obtenir des effets d'imagerie plus complexes. Les lentilles sont divisées en matériaux en verre et en plastique. Par exemple, 2G2P signifie que cet ensemble de lentilles est composé de deux lentilles en verre et de deux lentilles en plastique. En général, les lentilles en verre ont de meilleurs effets d'imagerie et sont plus chères.

2. VCM (moteur à bobine mobile)

Le nom complet est Voice Coil Motor, qui est un type de moteur en électronique. Comme le principe est similaire à celui d'un haut-parleur, on l'appelle un moteur à bobine mobile, qui présente les caractéristiques d'une réponse en haute fréquence et d'une haute précision. Son principe principal est de contrôler la position d'étirement de la feuille à ressort en modifiant le courant continu de la bobine dans le moteur dans un champ magnétique permanent, entraînant ainsi le mouvement de haut en bas. Les appareils photo des téléphones portables utilisent largement le VCM pour réaliser la fonction de mise au point automatique. La position de l'objectif peut être ajustée via le VCM pour présenter une image claire.

Une bobine est placée dans un champ magnétique permanent. Lorsque la bobine est alimentée, un champ magnétique est généré (loi d'Ampère), qui génère une attraction ou une répulsion avec l'aimant permanent périphérique, provoquant le déplacement de la bobine sous l'effet de la force. Si la lentille est placée sur la bobine, la bobine peut être entraînée pour se déplacer d'avant en arrière en modifiant la taille du courant, contrôlant ainsi la position de la lentille et complétant la fonction de mise au point.

Le VCM est généralement utilisé avec le circuit intégré de commande VCM (puce de commande VCM) et l'algorithme AF (mise au point automatique). Tout d'abord, l'image collectée par le capteur est entrée dans l'ISP, et l'algorithme AF de l'ISP calcule les étapes de mise au point de l'image actuelle et la transmet au circuit intégré de commande via I2C. Le circuit intégré de commande calcule le courant requis pour déplacer la bobine vers cette position, contrôlant ainsi avec précision le comportement de l'objectif pour obtenir l'effet de mise au point automatique. Bien entendu, cette méthode peut également obtenir l'effet du stabilisateur d'image optique (OIS), et le principe est le même.

Indicateurs de performance VCM

Les performances du VCM dépendent principalement du rapport entre le courant et la distance parcourue. À partir du courant de démarrage, l'augmentation du courant doit être proportionnelle à la distance parcourue. Plus le courant d'augmentation requis est faible, plus la précision est élevée. En même temps, cela dépend également de la consommation d'énergie maximale, de la puissance maximale et de la taille.

Classification VCM

Structurellement, elles peuvent être divisées en trois catégories : (1) structure de type ressort ; (2) structure de type bille ; (3) structure de type friction.

En fonction de leurs fonctions, ils peuvent être grossièrement divisés en cinq catégories : (1) Moteur à boucle ouverte ; (2) Moteur à boucle fermée ; (3) Moteur alternatif ; (4) Moteur de stabilisation d'image optique OIS (divisé en type de translation, type d'inclinaison-décalage, type de métal à mémoire, etc.) ; (5) Moteur OIS+boucle fermée à six axes.

Principe AF

Après être entré dans le mode de mise au point automatique, le pilote augmente de 0 à la valeur maximale, ce qui fait que l'objectif se déplace de sa position d'origine au déplacement maximal. À ce moment, la surface d'imagerie du capteur prend automatiquement des photos et les enregistre dans le DSP. Le DSP calcule la valeur MTF (fonction de transfert de modulation) de chaque image à travers ces images, puis trouve la valeur maximale dans cette courbe MTF. Grâce à l'algorithme, il obtient la taille du courant correspondant à ce point et demande à nouveau au pilote de fournir ce courant à la bobine mobile, de sorte que l'objectif soit stabilisé sur cette surface d'imagerie, de manière à obtenir une mise au point automatique.

Zoom et mise au point

A : Pour obtenir un zoom optique, un moteur de zoom (ZOOM) est utilisé

En déplaçant la lentille à l'intérieur de l'objectif pour modifier la position de la mise au point, en modifiant la distance focale de l'objectif et en modifiant l'angle de vue de l'objectif, l'effet peut être amplifié ou réduit.

B : Mise au point automatique à l'aide du moteur de mise au point (AF)

En déplaçant la position de l'objectif entier (plutôt que la lentille à l'intérieur de l'objectif) à une micro-distance, la distance focale de l'objectif est contrôlée pour obtenir des images claires. Il s'agit d'une méthode courante utilisée dans les téléphones portables.

La mise au point optique et le zoom optique sont des concepts différents :

Le zoom optique consiste à modifier la position de mise au point en déplaçant la position relative de l'objectif à l'intérieur de l'objectif, en modifiant la longueur de la distance focale de l'objectif et en modifiant l'angle de vue de l'objectif, obtenant ainsi un agrandissement et une réduction de l'image ;

La mise au point optique ajuste en fait la position de l'ensemble de l'objectif (plutôt que de la lentille à l'intérieur de l'objectif) pour contrôler la distance de l'image, rendant ainsi l'image plus claire.

3. Filtre infrarouge

La fonction du filtre anti-infrarouge est de filtrer la lumière infrarouge. La gamme de longueurs d'onde de la lumière que l'œil humain et les appareils photosensibles électroniques peuvent détecter est différente. La gamme de longueurs d'onde de la lumière que les appareils photosensibles électroniques peuvent détecter est bien plus large que celle des humains. Par conséquent, il est nécessaire de filtrer la lumière que l'œil humain ne peut pas détecter pour éviter qu'elle ne provoque des phénomènes de dominante de couleur et d'ondulation et pour améliorer la reproduction des couleurs. Cela aura un impact important sur le travail de réglage ultérieur du FAI.

Les filtres anti-IR sont divisés en deux catégories : les IR ordinaires et les IR en verre bleu. Le premier réfléchit la lumière infrarouge et ultraviolette, les empêchant de pénétrer dans le capteur, tandis que le second absorbe la lumière infrarouge et ultraviolette, les empêchant de pénétrer dans le capteur. Le premier provoque facilement de multiples réflexions de la lumière infrarouge, ce qui entraîne des ombres et de grandes différences de couleur dans l'effet d'imagerie final. Bien que le second ne présente pas ce problème et ait de meilleurs effets, son coût est également dix fois supérieur au premier.

4. Capteur d'images

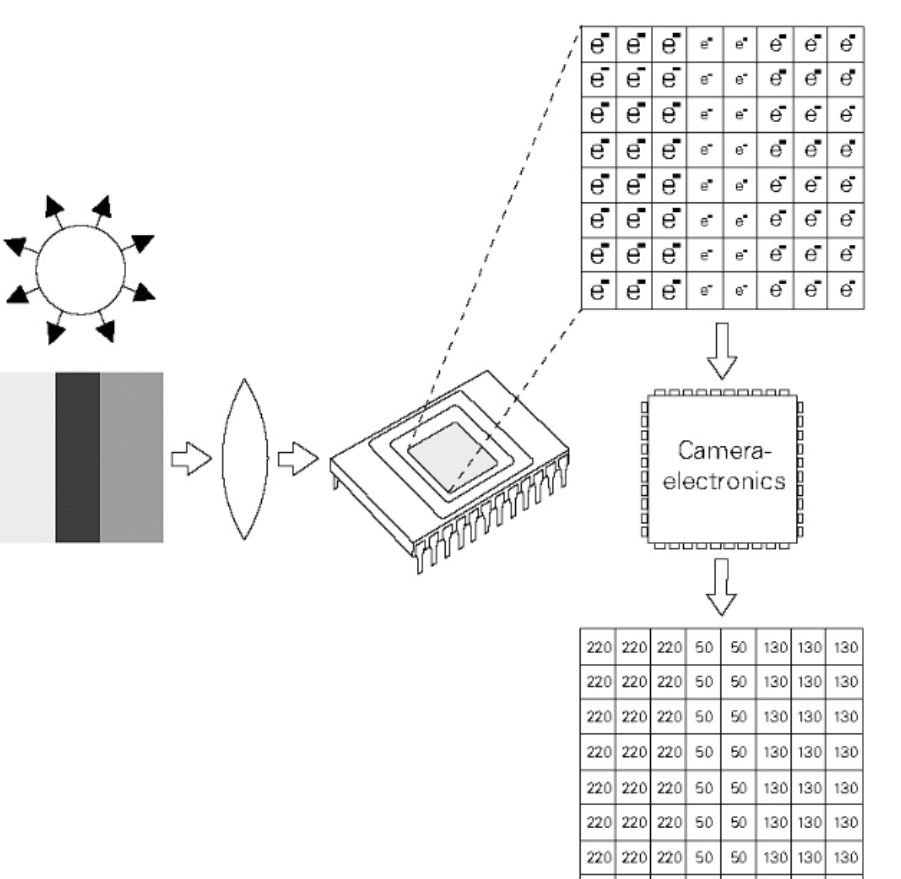

Le capteur d'image est le composant central de l'ensemble du module et l'objet de cette introduction. Il s'agit d'une puce semi-conductrice comportant des centaines de milliers à des millions de photodiodes à sa surface. Ces photodiodes génèrent des charges lorsqu'elles sont exposées à la lumière, convertissant ainsi les signaux lumineux collectés par la lentille en signaux électriques. Par conséquent, si le rôle de la lentille est équivalent à celui de la lentille de l'œil humain, alors le rôle du capteur est similaire à celui de la rétine, et les diodes photosensibles du capteur sont les cellules visuelles de la rétine.

Le capteur est principalement utilisé pour convertir les signaux lumineux externes collectés en signaux électriques que les systèmes électroniques ultérieurs peuvent traiter et stocker. Les unités photosensibles du capteur, c'est-à-dire chaque unité de pixel, sont disposées dans une matrice de pixels sur laquelle sont réparties des diodes photosensibles. Après avoir été stimulées par la lumière externe, ces diodes génèrent des signaux électriques de différentes intensités en fonction de l'intensité lumineuse, puis sont discrétisées en signaux numériques via une conversion A/N interne.

Une photodiode peut être considérée comme un condensateur. Plus la lumière est forte, plus la charge s'accumule simultanément sur le condensateur et plus la tension générée est élevée. Si la tension aux bornes du condensateur est convertie en signal numérique via A/N, une valeur numérisée peut être obtenue et tous les pixels peuvent être combinés pour obtenir une image en niveaux de gris. Plus la lumière est forte, plus la valeur est élevée et plus le pixel est proche du blanc ; plus la lumière est faible, plus la valeur est faible et plus le pixel est proche du noir. Cela est cohérent avec notre cognition habituelle.

Selon les différents types de diodes photosensibles, les capteurs largement utilisés sur le marché peuvent être divisés en deux catégories : les capteurs CCD et les capteurs CMOS. Le CCD est un dispositif à couplage de charge, c'est-à-dire un dispositif à couplage de charge ; le CMOS est un semi-conducteur à oxyde métallique complémentaire. Les principes de photosensibilité spécifiques des deux semi-conducteurs ne sont pas le sujet de cet article et ne seront pas abordés en détail. À l'heure actuelle, le capteur CMOS a essentiellement remplacé la position du capteur CCD précédent en raison de ses avantages de faible consommation, de vitesse de traitement plus rapide et de coût de fabrication inférieur, en particulier dans le domaine des téléphones portables et des appareils mobiles. Cependant, l'avantage du capteur CCD est qu'il fonctionne mieux dans des conditions de faible luminosité, n'est pas affecté par le bruit numérique comme le CMOS et ne dépend pas autant du travail de débruitage de l'ISP.

Le capteur d'image est une puce semi-conductrice dotée de millions à des dizaines de millions de photodiodes à sa surface. Lorsque les photodiodes sont exposées à la lumière, elles génèrent une charge électrique et convertissent la lumière en signaux électriques. Sa fonction est similaire à celle des yeux humains, de sorte que les performances du capteur affecteront directement les performances de l'appareil photo.

4.1 Structure du capteur

4.2 Classification

Élément photosensible : CCD, CMOS (PPS et APS)

Différents procédés : FSI éclairé par l'avant, BSI rétroéclairé, empilé

4.3 Indicateurs

1. Pixels

Le capteur est doté de nombreuses unités photosensibles, qui peuvent convertir la lumière en charge électrique pour former une image électronique correspondant à la scène. Dans le capteur, chaque unité photosensible correspond à un pixel. Plus il y a de pixels, plus il peut détecter de détails de l'objet, donc plus l'image est claire. Plus le nombre de pixels est élevé, plus l'effet d'imagerie est clair. Le produit de la résolution de l'appareil photo est la valeur du pixel, par exemple : 1280×960=1228800

2. Taille de la cible

La taille de la partie photosensible du capteur d'image est généralement exprimée en pouces. Comme pour un téléviseur, cette donnée fait généralement référence à la longueur diagonale du capteur d'image, par exemple 1/3 de pouce. Plus la surface cible est grande, meilleure est la transmission de la lumière, tandis que plus la surface cible est petite, plus il est facile d'obtenir une plus grande profondeur de champ.

3. Sensibilité à la lumière

Autrement dit, l'intensité de la lumière incidente est détectée par le CCD ou le CMOS et les circuits électroniques associés. Plus la sensibilité est élevée, plus la surface photosensible est sensible à la lumière et plus la vitesse d'obturation est élevée, ce qui est particulièrement important lors de la prise de vue de véhicules en mouvement et de la surveillance de nuit.

4. Obturateur électronique

Il s'agit d'un terme proposé en comparaison avec la fonction d'obturateur mécanique d'un appareil photo. Il contrôle le temps de photosensibilité du capteur d'image. Étant donné que la valeur de photosensibilité du capteur d'image est l'accumulation de la charge du signal, plus la photosensibilité est longue, plus le temps d'accumulation de la charge du signal est long et plus l'amplitude du courant du signal de sortie est grande. Plus l'obturateur électronique est rapide, plus la sensibilité est faible, ce qui convient aux prises de vue sous une forte lumière.

5. Fréquence d'images

Il s'agit du nombre d'images enregistrées ou lues par unité de temps. La lecture continue d'une série d'images produit un effet d'animation. Selon le système visuel humain, lorsque la vitesse de lecture d'images est supérieure à 15 images/seconde (soit 15 trames), l'œil humain peut à peine voir l'image sauter ; lorsqu'elle atteint entre 24 images/s et 30 images/s (soit 24 à 30 trames), le phénomène de scintillement est pratiquement imperceptible.

Les images par seconde (ips) ou la fréquence d'images indiquent le nombre de fois par seconde que le capteur graphique peut mettre à jour lors du traitement d'un champ. Une fréquence d'images plus élevée se traduit par une expérience visuelle plus fluide et plus réaliste.

6. Rapport signal/bruit

Il s'agit du rapport entre la tension du signal et la tension du bruit, et l'unité du rapport signal/bruit est le dB. En général, la valeur du rapport signal/bruit donnée par la caméra est la valeur lorsque l'AGC (contrôle automatique du gain) est désactivé, car lorsque l'AGC est activé, il renforce le faible signal, de sorte que le niveau de bruit augmente également en conséquence.

La valeur typique du rapport signal/bruit est de 45 à 55 dB. Si elle est de 50 dB, l'image présente une petite quantité de bruit, mais la qualité de l'image est bonne ; si elle est de 60 dB, la qualité de l'image est excellente et il n'y a pas de bruit. Plus le rapport signal/bruit est élevé, meilleur est le contrôle du bruit. Ce paramètre est lié au nombre de points de bruit dans l'image. Plus le rapport signal/bruit est élevé, plus l'image est nette et moins il y a de points de bruit en forme de point dans l'image de vision nocturne.

4.4 FAI

4.4.1 DONNÉES BRUTES

Le capteur convertit la lumière transmise par l'objectif en un signal électrique, puis la convertit en un signal numérique via l'AD interne. Étant donné que chaque pixel du capteur ne peut détecter que la lumière R, la lumière B ou la lumière G, chaque pixel stocke à ce moment des données monochromes, que nous appelons données RAW DATA. Pour restaurer les données RAW DATA de chaque pixel aux trois couleurs primaires, l'ISP doit les traiter.

4.4.2 Traitement par le FAI

L'ISP (Image Signal Processing) est principalement responsable du traitement des images numériques et de la conversion des données brutes collectées par le capteur dans un format pris en charge par l'algorithme.

Procédé spécifique :

1. Une fois que la lumière externe traverse la lentille, elle est filtrée par le filtre couleur puis brille sur la surface du capteur ;

2. Le capteur convertit la lumière transmise par l'objectif en un signal électrique, puis la convertit en un signal numérique via l'AD interne.

3.1. Si le capteur n'intègre pas l'ISP, il transmet directement la bande de base via la ligne de transmission (la bande de base est la bande de fréquence de base, voir « Principes de communication » pour plus de détails ; l'autre est la transmission par modulation de mode), et le format de données à ce stade est RAW DATA.

3.2. Si l'ISP est intégré, les données RAW DATA sont traitées par AWB (balance des blancs automatique), matrice de couleurs, ombrage de l'objectif, gamma, netteté, AE (contrôle d'exposition automatique) et débruitage, puis génèrent des données au format YUV ou RVB.

4.4.3 « Principes de communication » – Bande de base

Le nom complet de la bande de base en anglais est Baseband, qui peut également être traduit par la bande de fréquence (largeur de bande de fréquence) inhérente au signal électrique d'origine envoyé par la « source » (source d'information, également appelée terminal émetteur) sans modulation (décalage et transformation du spectre), appelée bande de fréquence de base, ou bande de base en abrégé. La bande de base correspond à la bande de fréquence, bande de fréquence : la bande passante de fréquence occupée par le signal en bande de base avant modulation (la différence entre la fréquence la plus basse et la fréquence la plus élevée occupée par un signal).

5. DSP

Fonction du processeur de signal numérique DSP (DIGITAL SIGNAL PROCESSING) : principalement grâce à une série d'algorithmes mathématiques complexes, pour optimiser les paramètres des signaux d'image numérique et les signaux traités via USB et d'autres interfaces vers PC et autres appareils

Différence entre DSP et ISP

Glossaire:

ISP est l'abréviation de Image Signal Processor, qui est un processeur de signal d'image.

DSP est l'abréviation de Digital Signal Processor, qui est un processeur de signal numérique.

Explication fonctionnelle :

L'ISP est généralement utilisé pour traiter les données de sortie du capteur d'image, telles que l'AEC (contrôle automatique de l'exposition), l'AGC (contrôle automatique du gain), l'AWB (balance automatique des blancs), la correction des couleurs, l'ombrage de l'objectif, la correction gamma, la suppression des pixels défectueux, le niveau de noir automatique, le niveau de blanc automatique, etc. (Pour plus de détails, veuillez visiter : https://blog.csdn.net/djfjkj52/article/details/115324741 pour une explication de « Exposition automatique de l'appareil photo, mise au point automatique, balance des blancs automatique, ISP, traitement d'image et modèle de couleur, espace colorimétrique »)

Le DSP a plus de fonctions. Il peut prendre des photos et les afficher (encodage et décodage JPEG), enregistrer et lire (encodage et décodage vidéo), encodage et décodage H.264 et de nombreuses autres fonctions de traitement. En bref, il traite les signaux numériques.

6. Circuit imprimé flexible

La fonction principale du circuit imprimé flexible (FPCB) est de connecter les composants au processeur principal et de compléter la fonction de transmission de données d'origine entre le capteur et le processeur principal.

7. Le processus d'imagerie des caméras de téléphones portables

Lien vers la caméra du téléphone portable

Commençons d'abord par examiner le lien global de l'appareil photo du téléphone portable. Il y a 5 étapes au total. Cet article explique les 3 premières parties (partie matérielle) :

Objectif de l'appareil photo : L'objectif de l'appareil photo d'un téléphone mobile. La lumière traverse l'objectif et atteint le capteur d'image COMS.

Capteur d'image : Le capteur d'image CMOS convertit le signal lumineux en signal électrique, puis le convertit en signal numérique via l'ADC interne.

ISP : Le signal numérique est transmis à l'ISP pour traitement, principalement pour la correction, la balance des blancs, le contrôle de l'exposition, etc.

SOC : Cette étape se situe au niveau de la couche applicative (par exemple App). Les données d'image sont post-traitées par le CPU et le GPU, par exemple en ajoutant des filtres, etc.

Affichage : Enfin, les données de l'image s'affichent sur l'écran